Популярные примеры использования Обновить журнал Статьи

Веб-сканеры и парсинг веб-страниц: браузер Bit Fingerprint внимательно рассматривает их сходства и различия

время: 2024-07-04 10:16 нажмите:

В обширной области сбора и обработки данных термины «сканер» и «сканирование» часто вызывают путаницу, особенно в технической литературе и дискуссиях. Хотя в некоторых контекстах они кажутся взаимозаменяемыми, на самом деле они содержат глубокие различия и связи. Цель этой статьи — прояснить туман и подробно остановиться на границах и общих чертах между поисковыми роботами и парсингом веб-страниц.

Четкое определение

Веб-скрапинг: относится к процессу извлечения и сбора необходимой информации с веб-страниц с помощью автоматизированных средств. Обычно это включает отправку HTTP-запросов на целевую веб-страницу, получение возвращенного содержимого HTML и извлечение из него определенных данных с использованием методов анализа (таких как регулярные выражения, XPath, селекторы CSS или более продвинутые библиотеки, такие как BeautifulSoup, Scrapy). Сканирование веб-страниц во многом зависит от структуры целевой веб-страницы и часто настраивается для конкретных наборов данных.

Веб-сканирование: это более широкая стратегия исследования, предназначенная для перемещения по Всемирной паутине, обнаружения и индексирования содержимого веб-страниц. Веб-сканеры (или веб-пауки) начинают с одного или группы начальных URL-адресов (называемых исходными URL-адресами), переходят по ссылкам на веб-страницах, рекурсивно посещают и записывают страницы, на которые указывают эти ссылки. Этот процесс не ограничивается извлечением данных, а фокусируется на обнаружении и картировании веб-страниц, предоставлении основных данных для индексации поисковыми системами, анализа контента веб-сайтов и т. д.

Анализ различий

Цель и направленность: сканирование веб-страниц направлено на извлечение ценных данных с конкретных веб-страниц, таких как цены, комментарии, новости и т. д.; в то время как веб-сканеры сосредоточены на всестороннем исследовании сетевых структур и сборе как можно большего количества информации о веб-страницах.

Технология и реализация. Хотя обе технологии включают в себя такие технологии, как HTTP-запросы и ответы, а также анализ веб-страниц, сканирование веб-страниц часто требует настройки правил синтаксического анализа, основанных на конкретной структуре целевой веб-страницы, в то время как веб-сканеры больше внимания уделяют обходу ссылок и управлению ими, а также как эффективные механизмы хранения и поиска данных.

Масштаб и сложность: сканирование веб-страниц позволяет гибко регулировать масштаб в соответствии с потребностями: от сбора данных нескольких страниц до интеграции информации всего веб-сайта; в то время как веб-сканеры обычно требуют крупномасштабной обработки и хранения данных и предъявляют более высокие требования к системным ресурсам, эффективности алгоритмов и управлению данными.

Этические и юридические соображения. Оба должны столкнуться с этическими и юридическими проблемами, такими как авторские права на веб-сайт, протокол robots.txt и ограничения частоты запросов. Однако из-за широкого распространения и потенциального воздействия веб-сканеров они с большей вероятностью вызовут споры и ограничения.

Сходства

Автоматизированная обработка: как сканирование, так и сканирование зависят от выполнения автоматизированных программ, что значительно повышает эффективность и точность сбора данных.

Техническая основа: оба построены на ключевых технологиях, таких как протокол HTTP, анализ HTML и хранение данных, и имеют схожие технологические стеки и принципы реализации.

Сценарии применения. Хотя цели и направленность различны, оба имеют широкую прикладную ценность во многих областях, таких как сбор данных, интеграция информации и поисковая оптимизация.

Тонкие различия между сканерами и сканерами

Хотя и краулеры, и краулеры в широком смысле подразумевают автоматическое извлечение данных, существуют существенные различия в деталях. Краулеры, как правило, осуществляют поиск на обширной территории, открывают новые ресурсы, переходя по ссылкам, и строят сетевые карты; в то время как сканеры больше внимания уделяют извлечению необходимых данных с конкретных веб-сайтов или страниц. Эта разница определяет их различия в технической реализации, сценариях применения и этических соображениях.

Законность

Возможно, вам будет интересно узнать, что большинство веб-сайтов в Интернете запрещают использование любого вида автоматизированного программного обеспечения на своих веб-страницах, за исключением популярных поисковых систем. Для тех веб-сайтов, которые это допускают, они предоставляют официальный API, а веб-сканеры и парсинг обычно не используют API. Это означает, что независимо от того, разрабатываете ли вы сканер или краулер, вы напрямую нарушаете условия использования целевого веб-сайта. Однако это не означает, что такое поведение незаконно. Фактически, сканирование и очистка общедоступных данных на веб-сайтах совершенно законны. Однако технические детали могут сделать это незаконным.

Ключевые инструменты для сканирования и очистки браузеров отпечатков пальцев:

В эпоху Интернета, управляемого данными, парсинг веб-страниц как важное средство получения информации все чаще становится предметом внимания эффективности и безопасности. Традиционные краулерные технологии часто оказываются неспособными справиться с источниками данных со сложными защитными механизмами, особенно когда они сталкиваются с источниками данных. Если вы не будете осторожны, это может привести к срабатыванию механизма защиты от сканирования, что приведет к затруднению выполнения задачи сканирования или даже к блокировке IP-адреса. Именно в этом контекстеБраузеры с отпечатками пальцев, с их уникальными преимуществами, переосмысливают возможности парсинга веб-страниц.

Невидимый плащ, который меняет экосистему веб-сканирования

Браузер отпечатков пальцев, продукт этой технологической инновации, — это не просто обновление браузера. Это больше похоже на слой невидимого плаща для автоматизированного сценария, позволяющий ему свободно перемещаться в цифровом мире, оставаясь незамеченным. Глубоко моделируя поведение реальных пользователей при просмотре страниц, браузер отпечатков пальцев ловко обходит различные методы обнаружения веб-сайта, включая, помимо прочего, подробный анализ поведения пользователей, сложное сравнение отпечатков пальцев устройств и т. д., обеспечивая беспрецедентную гибкость и безопасность для задач веб-сканирования.

Основные преимущества: за пределами традиционной маскировки и манипуляций.

Полная маскировка отпечатков пальцев. Браузер отпечатков пальцев не ограничивается модификацией пользовательского агента, но также может выполнять глубокую маскировку во многих измерениях, таких как механизм браузера, операционная система, модель устройства и т. д., для создания практически неотличимой виртуальной пользовательской среды. и полностью разрушить систему распознавания по отпечаткам браузера.

Изоляция среды и независимая конфигурация: каждая задача сканирования или учетная запись может иметь независимую среду браузера, включая независимые файлы cookie, кэш и локальное хранилище, чтобы гарантировать, что они не влияют друг на друга, обеспечивая прочную основу для комплексного управления несколькими учетными записями и усовершенствованного сканирования. стратегии.

Интеллектуальная динамическая ротация прокси и IP-адресов. Встроенная система управления прокси-серверами может автоматически выбирать и менять IP-адреса, эффективно скрывать реальный IP-адрес, снижать риск ограничений или запретов доступа, вызванных частым доступом, а также повышать эффективность сканирования.

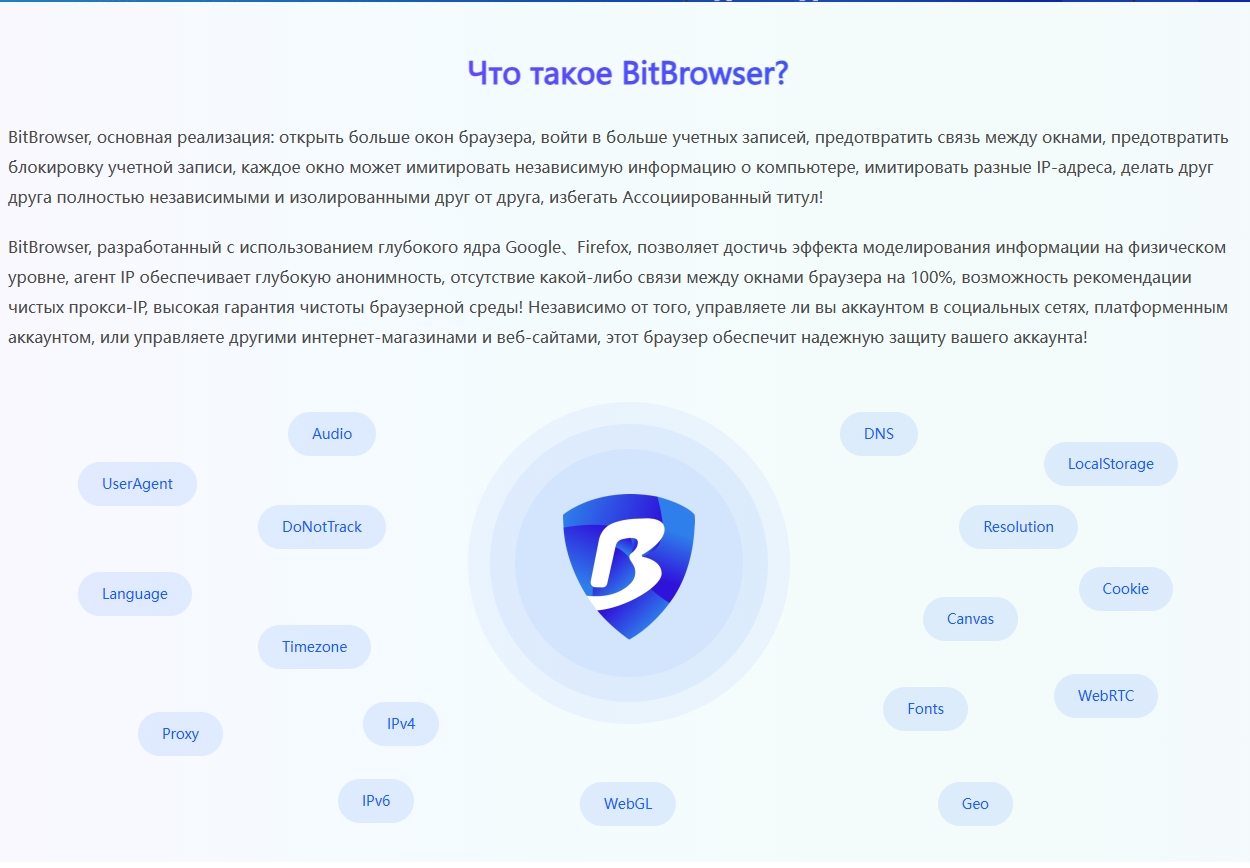

Среди многих браузеров отпечатков пальцев BitBrowser выделяется своей превосходной производительностью и широкими сценариями применения. Будучи браузером отпечатков пальцев, предназначенным для автоматизированных операций и сканирования веб-страниц, BitBrowser не только обладает всеми вышеперечисленными основными преимуществами, но также демонстрирует исключительную практическую ценность в трансграничной электронной коммерции, управлении социальными сетями, исследованиях рынка и других областях. Его мощная система управления учетными записями и функция автоматизации RPA упрощают трудоемкий вход в систему и работу с несколькими учетными записями в один клик, что значительно повышает эффективность и безопасность работы.

Краткое содержание:

Сегодня, когда данные стали играть важную роль, браузер Bit Fingerprint внес революционные изменения в область веб-сканирования благодаря своей уникальной невидимости и мощным возможностям контроля. Это не только способный помощник технических специалистов, но и важная сила, способствующая свободному потоку информации и процветанию цифровой экономики. Загрузите BitBrowser сейчас, чтобы получить более эффективную и безопасную среду для сканирования веб-страниц. Нажмите, чтобы загрузить и сразу получить 10 постоянных бесплатных окон.